Los robots aprenden a moverse observando a sí mismos

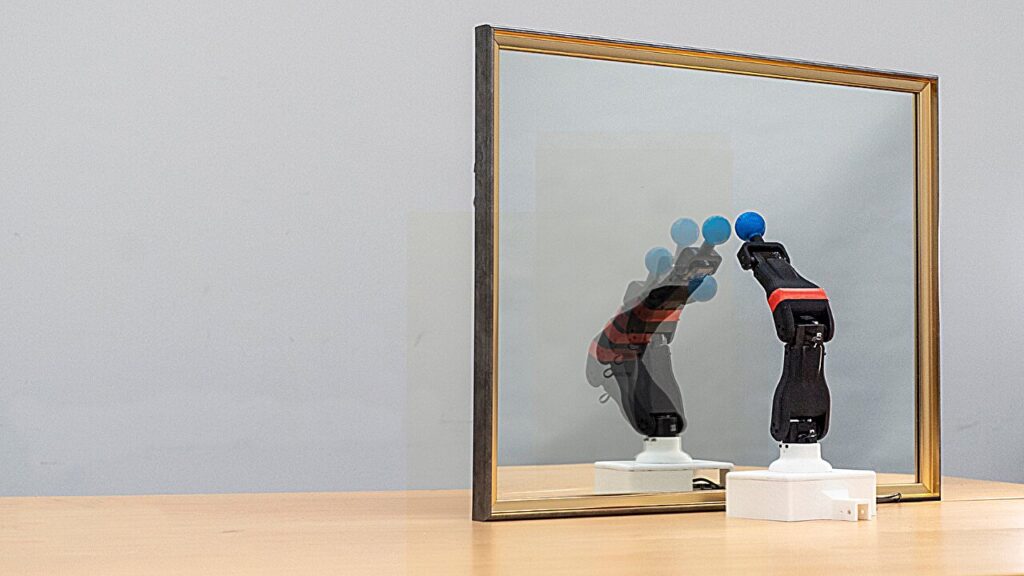

Un robot observa su reflejo en un espejo, aprendiendo su propia morfología y cinemática para la auto-simulación autónoma. El proceso destaca la intersección del aprendizaje y la robótica basados en la visión, donde el robot refina sus movimientos y predice su movimiento espacial a través de la autoobservación. Crédito: Jane Nisselson/Columbia Engineering

Al observar sus propios movimientos con una cámara, los robots pueden enseñarse sobre la estructura de sus propios cuerpos y cómo se mueven, revela un nuevo estudio realizado por investigadores de Columbia Engineering. Equipados con este conocimiento, los robots no solo podían planificar sus propias acciones, sino también superar el daño a sus cuerpos.

Los investigadores detallaron sus hallazgos en la revista Inteligencia de la máquina de la naturaleza.

“Al igual que los humanos que aprenden a bailar viendo su reflejo de espejo, los robots ahora usan videos crudos para construir autoconciencia cinemática”, dice el autor principal del estudio, Yuhang Hu, estudiante de doctorado en el Laboratorio de Máquinas Creativas de la Universidad de Columbia, dirigida por Hod Lipson, James y Sally Scapa Profesor de Innovación y Presidente del Departamento de Ingeniería Mecánica.

“Nuestro objetivo es un robot que comprende su propio cuerpo, se adapta al daño y aprende nuevas habilidades sin una programación humana constante”.

La mayoría de los robots primero aprenden a moverse en simulaciones. Una vez que un robot puede moverse en estos entornos virtuales, se libera al mundo físico donde puede seguir aprendiendo.

“Cuanto mejor y más realista sea el simulador, más fácil será para el robot dar el salto de la simulación a la realidad”, explica Lipson.

Sin embargo, crear un buen simulador es un proceso arduo, que generalmente requiere ingenieros calificados. Los investigadores enseñaron a un robot cómo crear un simulador de sí mismo simplemente observando su propio movimiento a través de una cámara.

“Esta habilidad no solo ahorra esfuerzo de ingeniería, sino que también permite que la simulación continúe y evolucione con el robot a medida que sufre desgaste, daño y adaptación”, dice Lipson.

En el nuevo estudio, los investigadores desarrollaron una forma para que los robots modelen de forma autónoma sus propias formas 3D utilizando una sola cámara 2D regular. Este avance fue impulsado por tres sistemas de IA que imitan el cerebro conocidos como redes neuronales profundas. Estos se infieren el movimiento 3D del video 2D, lo que permite al robot comprender y adaptarse a sus propios movimientos.

El nuevo sistema también podría identificar alteraciones en los cuerpos de los robots, como una curva en un brazo, y ayudarlos a ajustar sus movimientos para recuperarse de este daño simulado.

Dicha adaptabilidad podría resultar útil en una variedad de aplicaciones del mundo real. Por ejemplo, “Imagine una aspiradora de robot o un bot de asistente personal que se da cuenta de que su brazo está doblado después de toparse con los muebles”, dice Hu. “En lugar de romper o necesitar reparación, se observa a sí mismo, ajusta cómo se mueve y sigue funcionando. Esto podría hacer que los robots de la casa sean más confiables, no se requiere una reprogramación constante”.

Otro escenario podría involucrar a un brazo robot que no se desanimó en una fábrica de automóviles. “En lugar de detener la producción, podría verse a sí mismo, ajustar sus movimientos y volver a soldar, cultivando el tiempo de inactividad y los costos”, dice Hu. “Esta adaptabilidad podría hacer que la fabricación sea más resistente”.

A medida que entregamos funciones más críticas a los robots, desde la fabricación hasta la atención médica, necesitamos que estos robots sean más resistentes. “Los humanos no podemos permitirse el lujo de cuidar constantemente estos robots, reparar piezas rotas y ajustar el rendimiento. Los robots deben aprender a cuidarse de sí mismos si van a ser realmente útiles”, dice Lipson. “Es por eso que el auto-modelado es tan importante”.

La habilidad demostrada en este estudio es la última de una serie de proyectos que el equipo de Columbia ha lanzado en las últimas dos décadas, donde los robots están aprendiendo a mejorar en el modelaje usando cámaras y otros sensores.

En 2006, los robots del equipo de investigación pudieron usar observaciones para crear solo simulaciones simples similares a la figura de palo de ellos mismos. Hace aproximadamente una década, los robots comenzaron a crear modelos de mayor fidelidad utilizando múltiples cámaras.

En este estudio, el robot pudo crear un modelo cinemático integral de sí mismo usando solo un breve video clip de una sola cámara normal, similar a mirar en el espejo. Los investigadores llaman a esta nueva habilidad “Autodalidad cinemática”.

“Los humanos somos intuitivamente conscientes de nuestro cuerpo; podemos imaginarnos en el futuro y visualizar las consecuencias de nuestras acciones mucho antes de realizar esas acciones en realidad”, explica Lipson.

“En última instancia, nos gustaría imbuir a los robots con una capacidad similar para imaginarse, porque una vez que puedas imaginarte en el futuro, no hay límite para lo que puedes hacer”.

Más información:

Yuhang Hu et al, enseñando robots para construir simulaciones de sí mismos, Inteligencia de la máquina de la naturaleza (2025). Doi: 10.1038/s42256-025-01006-W

Proporcionado por

Escuela de Ingeniería y Ciencias Aplicadas de la Universidad de Columbia

Citación: Robots Aprenda a moverse observándose (2025, 25 de febrero) Consultado el 7 de marzo de 2025 de https://techxplore.com/news/2025-02-Robots.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.